中科院发布全球首颗AI全自动设计CPU,5小时生成无人工干预

近日,中科院处理器芯片全国重点实验室及其合作单位,用AI技术设计出了世界上首个无人工干预、全自动生成的CPU芯片——启蒙1号。

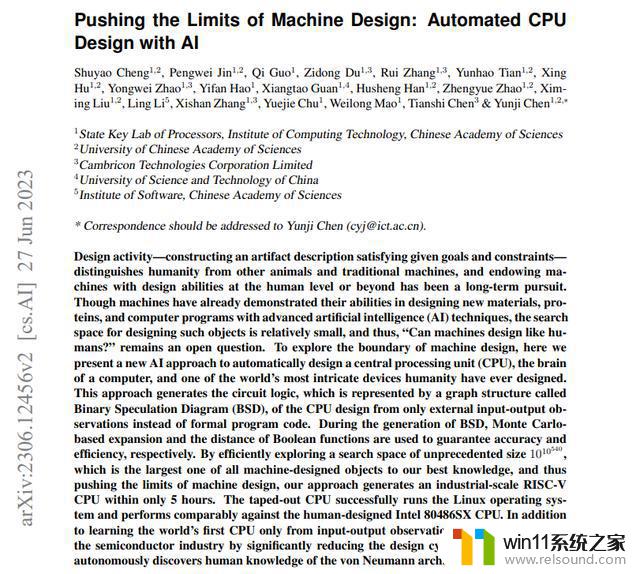

据悉,该CPU基于RISC-V的32位架构,它比GPT-4目前能够设计的电路规模大4000倍,性能与Intel 486系列CPU相当(注:英特尔486 CPU又称80486,英特尔于1989年制造成功,采用1微米制造工艺,内部继承了120万个晶体管),可运行Linux操作系统。该芯片已于2021年12月进行流片,采用65nm工艺制造,频率达到了300MHz。

这项研究,或将为半导体设计领域带来颠覆性的改革。

全球首款,AI全自动设计

训练5小时生成超400万逻辑门

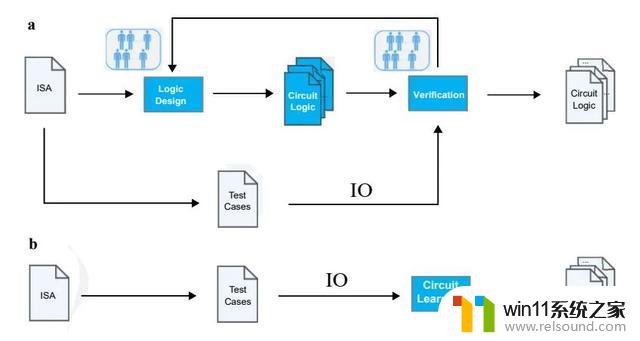

6月27日,来自中科院的团队在论文预印本平台arXiv上发表了重磅论文《Pushing the Limits of Machine Design:Automated CPU Design with AI》(推动机器设计的极限:使用人工智能自动设计CPU)。

论文地址:https://arxiv.org/pdf/2306.12456.pdf

论文中表明,团队使用人工智能,成功地在5个小时内完成了一个基于RISC-V指令集的CPU的设计,而且该设计经过后端布局布线后,已经成功流片点亮并且能运行Linux和Dhrystone。

“启蒙一号”芯片版图(a)和实物图(c)

该论文一经发表,便引来业界广泛关注。

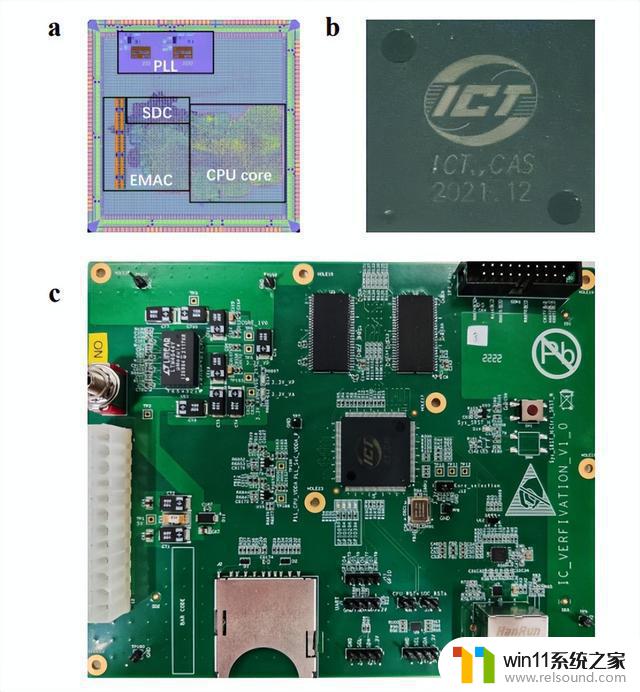

CPU的设计向来是一项复杂、耗费人力和资源的具有挑战性的工作,通常需要由工程师团队编写代码(如Verilog、Chisel或C/C++等),然后在EDA工具(如逻辑综合或高层次综合工具)的辅助下生成电路逻辑。

除此之外,工程师团队针对人工编写的代码,还需反复使用测试用例,对其进行迭代的功能验证和性能/功耗优化。

这一高度复杂的过程,通常需要花费数月或数年时间来完成。英特尔高级首席工程师Ophir Edlis曾透露,对于英特尔而言,研发一款CPU需要4年时间。

因此,为了提高设计效率,中科院团队一直以来都在尝试赋予AI人类水平的设计能力。

与传统CPU设计流程需要大量人工参与不同,为了在无人工干预情况下实现CPU设计自动化。研究人员基于BSD二元猜测图(Binary Speculation Diagram, 简称BSD)算法,采用AI技术直接从测试用例的输入-输出(IO)自动生成CPU设计,无需工程师提供任何代码或自然语言描述。

令团队惊喜的是,该方法在5小时内生成了超过4,000,000个逻辑门的32位RISC-V CPU——启蒙1号,比目前GPT-4所能设计的电路规模大4000倍,且达到了>99.999999999%的验证测试准确性。

传统CPU设计流程(a)与全自动CPU设计流程(b)

该方法甚至自主地发现了包含控制器和运算器等在内的冯诺依曼架构,为后续发现人类未知的体系结构优化知识提供了参考。

论文中表示,这是世界上第一个完全由AI设计的CPU,突破了机器设计的局限,为类人设计能力提供了明确的证据,它将可能通过显著缩短设计周期,来进一步改革半导体行业。

AI设计芯片

随着AI技术的迅猛发展,越来越多的公司开始将其引入芯片设计制造。

英伟达曾在今年3月的GTC大会上推出AI辅助制芯技术,能将计算光刻提速40倍,台积电、ASML等未来都将引入该技术(详情可参考《黄教主深夜丢“核弹”,加速光刻领域2nm制程、最新GPU提速10倍……》)。

另一芯片巨头AMD首席技术官Mark Papermaster也透露,目前AMD在半导体设计、测试与验证阶段均已开始应用AI,未来计划在芯片设计领域更广泛地使用生成式AI。

日前,纽约大学Tandon工程学院的研究人员也利用AI实现了一项重大突破。

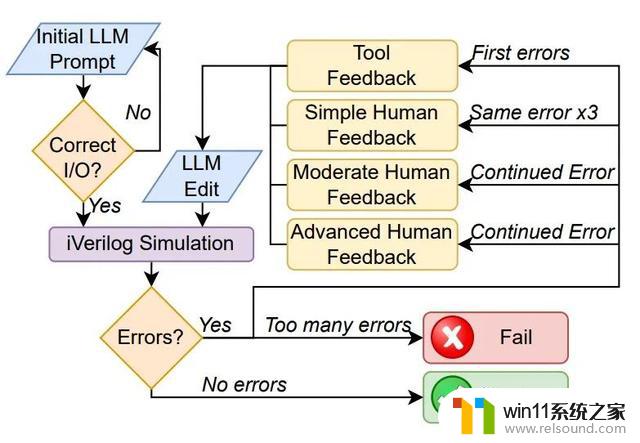

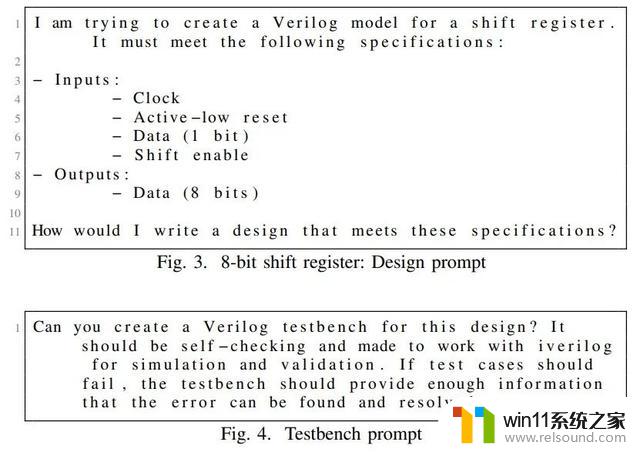

研究团队利用GPT-4与进行简单对话的方式,让GPT-4生成Verilog,成功设计出一款130nm工艺的处理器芯片。并且,这个芯片还被送去了 Skywater 130nm shuttle上流片。这一成就也被认为是史无前例的突破。

此外,研究人员还设置了设计流程图和评估标准,来给大语言模型在芯片设计方面的表现打分。对话框架形成了一个反馈循环。

通过这个「半自动化」流程,研究人员想对比一下4个大语言模型(GPT-4,ChatGPT,Bard,HuggingChat),执行芯片设计的能力。

评估流程图(论文地址:https://arxiv.org/pdf/2305.13243.pdf)

研究人员首先给大语言模型喂了如下图所示的提示词,让他们生成两种不同的文档。然后输出的内容研究人员会让有经验的工程师来评估是否能够使用。

如果输出内容达不到标准,研究人员会让大语言模型通过相同的提示词再输出5次。如果还不符合要求,那么就认为这个大语言模型无法完成这个工作流程。

最终结果是,GPT-4和ChatGPT成功胜出,都能够满足规范并最终通过了设计的整个流程。

纽约大学的这项研究,意味着在大语言模型的帮助下,芯片设计行业的大难题——HDL(硬件描述语言)将被攻克。

尽管“启蒙一号”的性能还处于30多年前的水平,但中科院的研究证明了,AI设计CPU的目标是能够实现的,这为我们扩大了机器设计的边界。

而我们用AI进行芯片设计的目的,也并不是取代人类工程师,而是如果大语言模型制作芯片能广泛应用到现实芯片设计中,工程师们就可以把精力集中在更具挑战性的方向,实现更多的创新与升级,与此同时,芯片公司也可以缩短芯片开发周期、节省一定的人工成本。

期待未来AI能为芯片行业带来更多可能。

参考资料:

中科院论文:Pushing the Limits of Machine Design: Automated CPU Design with AI

纽约大学论文:Chip-Chat: Challenges and Opportunities in Conversational Hardware Design

中科院发布全球首颗AI全自动设计CPU,5小时生成无人工干预相关教程

- AI要“成精”了?微软称其GPT-4已有“人类推理”迹象,预示着人工智能时代的全新飞跃

- 全球科技巨头集体自研AI芯片,意味着终结英伟达的统治?

- 微软发布Win11 Build 23451 Dev预览版更新:全新UI设计及性能提升

- 微软游戏部宣布裁员650人,全球员工减少3%

- NVIDIA CEO 黄仁勋发布面向各行各业的生成式 AI 平台,引领下一代人工智能技术发展!

- 安全部门成万人裁员收尾站,微软却想开启一个生成式AI杀毒时代

- 微软将发布两款人工智能增强型个人电脑,领先科技尽在微软AI电脑

- 超强升级!微软Win12也将加入AI,引爆全球科技界热议

- 微软CEO纳德拉宣布:Windows的“AI时刻”来了,微软全面拥抱人工智能技术!

- Quisitive与微软合作,开发生成式AI工具,助力医疗保健领域

- 英伟达新一代AI芯片过热延迟交付?公司回应称“客户还在抢”

- 全球第二大显卡制造商,要离开中国了?疑似受全球芯片短缺影响

- 国外芯片漏洞频发,国产CPU替代加速,如何保障信息安全?

- 如何有效解决CPU温度过高问题的实用方法,让你的电脑更稳定运行

- 如何下载和安装NVIDIA控制面板的详细步骤指南: 一步步教你轻松完成

- 从速度和精度角度的 FP8 vs INT8 的全面解析:哪个更适合你的应用需求?

微软资讯推荐

- 1 英伟达新一代AI芯片过热延迟交付?公司回应称“客户还在抢”

- 2 微软Win11将为开始菜单/任务栏应用添加分享功能,让你的操作更便捷!

- 3 2025年AMD移动处理器规格曝光:AI性能重点提升

- 4 高通Oryon CPU有多强?它或将改变许多行业

- 5 太强了!十多行代码直接让AMD FSR2性能暴涨2倍多,性能提升神速!

- 6 当下现役显卡推荐游戏性能排行榜(英伟达篇)!——最新英伟达显卡游戏性能排名

- 7 微软发布Win11 Beta 22635.4440预览版:重构Windows Hello,全面优化用户生物识别体验

- 8 抓紧升级Win11 微软明年正式终止对Win10的支持,Win10用户赶紧行动

- 9 聊聊英特尔与AMD各自不同的CPU整合思路及性能对比

- 10 AMD锐龙7 9800X3D处理器开盖,CCD顶部无3D缓存芯片揭秘

win10系统推荐